Dejando de lado que un troll es un troll se hable de Windows, Linux o el tiempo en Siberia, y que el concepto que tenemos todos de "nuestros motivos razonados" es cualquier cosa menos razonable, lo que a mí me resulta más llamativo es la idea del usuario sufridor de Linux, el friki que destina horas a encontrar la forma más enrevesada de hacer cualquier cosa.

En ForoSUSE los moderadores solemos decirle a los aforados que abren hilos distribución vs distribución que su opinión siempre se va a ver sesgada por la respuesta de tales distribuciones al hardware que tienen. Así, por ejemplo, el que la instalación sea sencilla, los programas disponibles los mejores y demás no sirve de mucho si no es posible utilizar la tarjeta wifi que tiene nuestro portátil. Por supuesto, de todas formas "ser difícil de instalar" es mejor que ser "imposible".

La mayoría de computadores personales (de escritorio o portátiles) trae Windows preinstalado. Eso, por definición, hace que la impresión sea buena al principio, ya que todo funciona sin nuestra intervención. Incluso cuando todo falla y debemos recomponer el sistema, sabemos que los drivers de nuestros dispositivos están disponibles -si no se incluyen en Windows, estarán al menos en el CD que viene con el equipo, en una partición del disco de un portátil, en la web de los fabricantes...- ya que sabemos que al menos hasta ahora lo estaban; y lo sabemos porque lo estábamos usando.

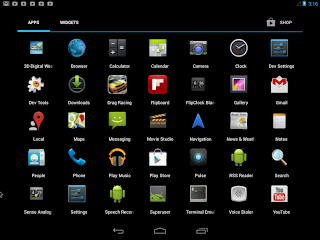

Android proporciona muchas pistas y lecciones valiosas. La primera, que no existe ninguna fobia extraña hacia Linux en general; la segunda, que en contra de lo que siempre se había dicho, realmente cualquier usuario puede usar el sistema.

Android y Linux

Android es un forma de LInux, así que ¿por qué alguien que usa Android podría tener un punto de vista negativo sobre Linux en el escritorio?

Android viene preinstalado. Es más, muchos fabricantes deshabilitan el sistema para seleccionar el sistema a arrancar, aun cuando puede restaurarse dicha posibilidad con relativa sencillez. Incluso suelen añadir una selección propia de software, en parte para compensar la omnipresencia de Google. De forma adicional, el repositorio de aplicaciones básico es el que viene preconfigurado en el sistema (google-play). Si bien pueden añadirse otro, en éste se encuentra la práctica totalidad de las aplicaciones a utilizar por cualquier usuario.

Por su parte, GNU/Linux cultivó durante mucho tiempo la imagen de "Sistema de Hackers". Lo cierto es que muchos usuarios no hacemos mucho por mejorar tal imagen, echando mano de la consola con irritante (para muchos usuarios de Windows) frecuencia, simplemente porque nos resulta más cómodo.

Suele ser vano ejercicio contarle al público general que cualquier escritorio de GNU/Linux es más sencillo de usar que Android. La tienda de aplicaciones, donde la mayoría son gratuitas, tiene parte de culpa. Un usuario de Android espera usar el smartphone para mandar mensajes por mensajería como Whatsapp o Line y si acaso utilizar alguna aplicación o juego que se ponga de moda. En tal caso, buscarla le resulta sencillo, y la instala con mayor sencillez aún.

Suele ser vano ejercicio contarle al público general que cualquier escritorio de GNU/Linux es más sencillo de usar que Android. La tienda de aplicaciones, donde la mayoría son gratuitas, tiene parte de culpa. Un usuario de Android espera usar el smartphone para mandar mensajes por mensajería como Whatsapp o Line y si acaso utilizar alguna aplicación o juego que se ponga de moda. En tal caso, buscarla le resulta sencillo, y la instala con mayor sencillez aún.La mayoría de distribuciones de GNU/Linux instalan software con la misma o incluso mayor sencillez; pero suelen tener el software en varios lugares, y el sistema tal cual lo instalamos sólo acostumbra a tener algunos de ellos configurados por defecto. Por ejemplo, normalmente para instalar una aplicación como Jdownloader el usuario primero debe de añadir el repositorio donde se encuentra. No se trata de que sea sencillo o no añadir un repositorio: se trata de que no está hecho, y hacerlo implica no sólo la actividad en sí, sino en saber qué repositorio contiene el software.

Claro que las distribuciones no gestionan esos repositorios así para molestar al usuario. Al contrario que las tiendas de aplicaciones, son las comunidades y no los desarrolladores los que mantienen el software disponible. Su tiempo para probarlo y empaquetarlo es finito, al igual que el espacio en los servidores para alojar dicho software.

También Android tiene otros repositorios para software que por diversas razones no acabe en su store. La inmensa mayoría de los usuarios ni siquiera sabe nada de ellos, aun cuando en los primeros momentos de la expansión de Android la existencia de tales repositorios, y la complacencia de Android para utilizarlos (al contrario que iOS, que los evita como la peste) fuese uno de los motivos habitualmente aducidos para decantarse por Android.

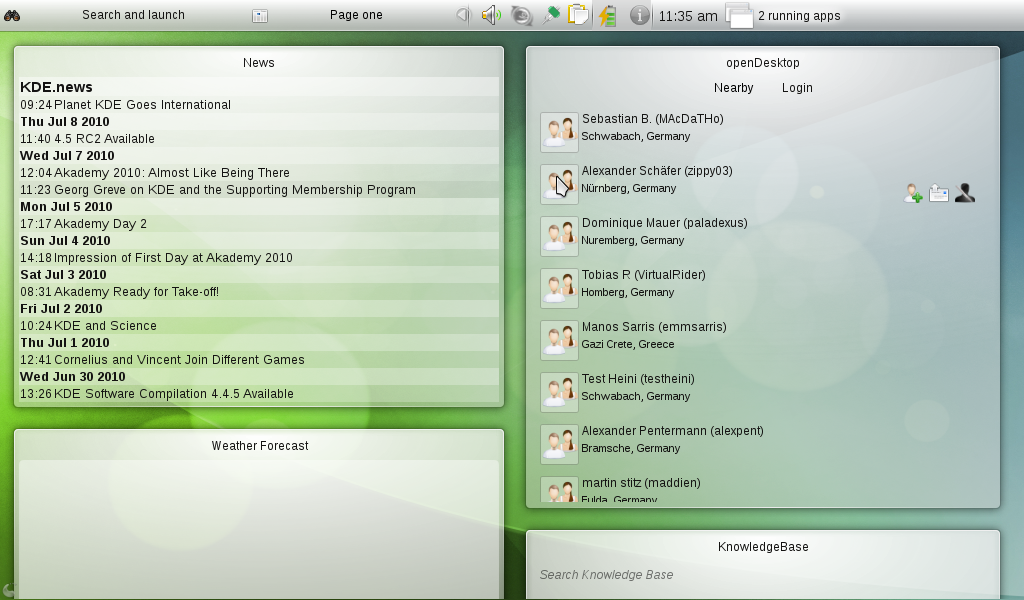

Ubuntu emplea una aproximación interesante a los store de Google y Apple; pero naturalmente el software que maneja está restringido al disponible en los repositorios configurados por defecto, como es de esperar. openSUSE emplea una idea mejor aun para el software, pero no es una tienda: ni hay software de pago ni hay otros materiales habituales en los store: libros, etc. openSUSE utiliza un sistema centralizado para gestionar los repositorios, tanto para su comunidad como para cualquiera que se registre, llamado Build Service. Un buscador web es una herramienta natural para buscar paquetes en todos los repositorios contenidos en el Build Service. El buscador es capaz de buscar paquetes por grupos (ofimática, gráficos...) e incluso para otros sistemas distintos de openSUSE (que usen, naturalmente, el Build Service). Pero no deja de ser una herramienta típica de GNU/Linux: los usuarios no tienen una forma sencilla de ver valoraciones, estadísticas de descarga, etc.

La administración de Android no es sencilla en absoluto, pero sí provee formas muy fáciles de efectuar unas cuantas tareas más o menos básicas. Por ejemplo, utilizar un smartphone como punto de acceso a Internet para un portátil es cuestión de hacer un click en la opción llamada, oportunamente, "Punto de acceso". Otra forma de hacer la vida ás sencilla a los usuarios de Android es que Android no utiliza el mismo concepto de usuario que los escritorios: para Android, cada aplicación es un usuario que puede compartir o no recursos con otros usuarios (otras aplicaciones).

Cualquier sistema con Android provee una configuración básica para el usuario: en márketing, eso lo llaman "experiencia de usuario". Los escritorios de Linux no hacen nada de eso: casi siempre proporcionan un escritorio básico sobre el que el usuario puede hacer los cambios que estime oportuno. Es curioso que abunden las distribuciones creadas sobre la base de que los usuarios necesitan otras cosas que no proveen las existentes, y sin embargo escaseen las personalizaciones de escritorio (más allá de temas, gráficos o fuentes).

PclinuxOS FullMonty es una aproximación a la idea de proporcionar una experiencia de usuario más personalizada. Tiene varias actividades que muestran en pantalla los accesos directos a las aplicaciones relacionadas, e incluso con xbmc, un reproductor multimedia al uso.

Una buena idea de Android es gestionar los ficheros como si fueran entidades diferenciadas; sin embargo, esto no es más que uno de los conceptos incluidos en la "experiencia de usuario" mencionada más arriba. Por ejemplo, si tú estás en un reproductor de vídeo, Android te lista los ficheros de vídeo disponibles, bien en el almacenamiento del dispositivo o bien en una tarjeta externa. En este último caso, Android listará directamente dichos ficheros, evitando al usuario la molestia de buscarlos. Bueno, eso si se permite que la tableta haga manipule la tarjeta a su antojo, claro. En lugar de listar una serie de carpetas de una tarjeta, alguna de las cuáles contendrá vídeos, Android lista los vídeos directamente. No es tecnología punta, precisamente, pero ya viene hecho.

Lo fácil y lo difícil

Para cualquier persona, el conjunto de tareas que sabe hacer resultan sencillas, mientras que cualquier conjunto de tareas que tenga que aprender a realizar son más complejas. Es, por supuesto, un punto de vista subjetivo, pero válido; sin embargo, es común tender a generalizar y llegar a supuestos del tipo "si es más fácil para mí (o para muchos), también lo es para ti".En las discusiones sobre escritorios y sistemas operativos los usuarios de Windows (o, desde hace unos pocos años, los de Macintosh, aun cuando los modernos Mac OS X horrorizarían a los usuarios de versiones anteriores) suelen describir una serie de tareas que realizan con el computador como ejemplo de lo fácil que es usar el sistema. Para empeorarlo, los usuarios de otros sistemas como GNU/Linux se enzarzan en demostrar la bondad de los métodos alternativos para hacer exactamente lo mismo.

Hay un hilo por ahí acerca de los motivos supuestos por los que Gimp y Writer no podrían (según el autor) reemplazar nunca a Photoshop y Word para la gran mayoría de usuarios. Quien haya leído atentamente este artículo, estará preparado para pensar que igual que el usuario no parece haber sufrido mucho para adaptarse a Android, algo así podría suceder con sus aplicaciones.

Observemos entonces alguna de las "razones" argüidas para que la "gran masa" de usuarios no usen nunca GIMP o Writer.

- Un usuario novato no encontrará la forma de dibujar un simple cuadrado en GIMP. Lo que no se indica es que hace tal usuario novato utilizando GIMP para dibujar un cuadrado en primer lugar. Es cierto que la mayoría de distribuciones instalan GIMP como herramienta gráfica lo que puede causar en primer lugar la impresión de que GIMP sea la aplicación de dibujo provista por la distribución. Pero GIMP no es una herramienta de dibujo, y su objetivo está lejos de eso. Por esa regla de tres, GIMP no es un programa de dibujo vectorial, como tampoco lo es Photoshop. No veo al autor del hilo suponiendo la falta de calidad para el usuario medio de Photoshop porque sea más difícil manipular formas básicas. Podemos aun dudar de las capacidades de Photoshop (y de GIMP) para el diseño CAD. En fin, vemos rápidamente que esto no llega a ninguna parte.

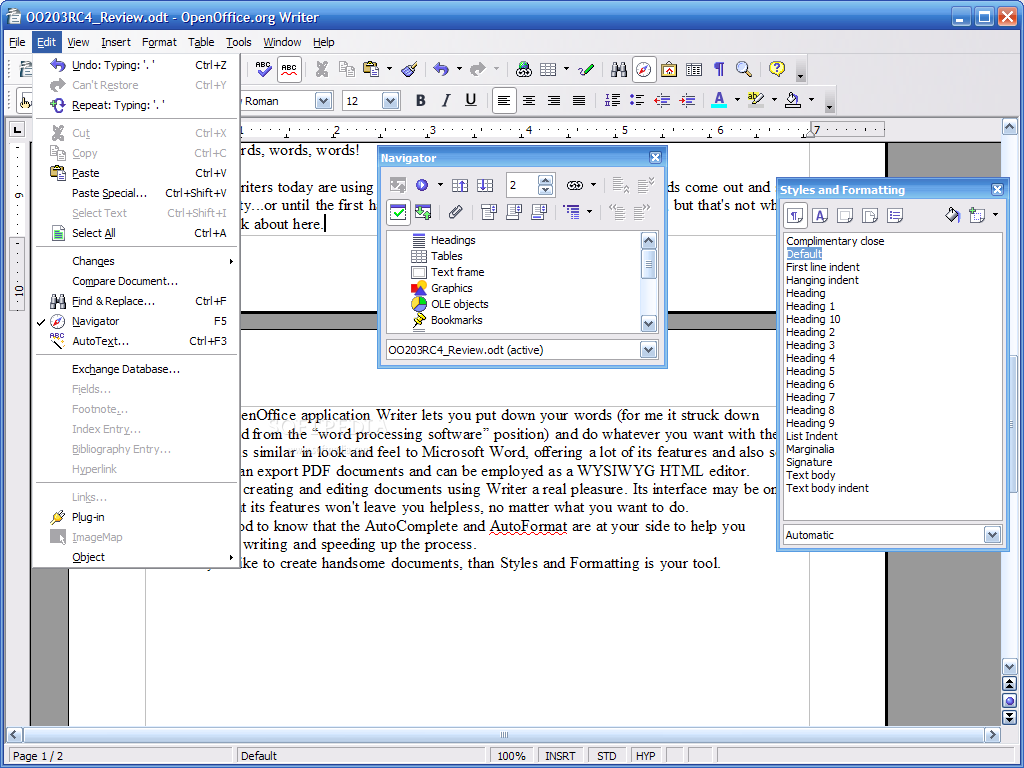

- En MS-Office puedes seleccionar el color deseado para los encabezados (entiendo que para cualquier tipo de párrafo), por ejemplo el #339933 (que me imagino es una suerte de verde). No deja de ser curioso cómo se supone que los usuarios "estándar" son unos completos negados e ineptos para muchas cosas relativamente simples, mientras que para otras cosas tienen un conocimiento increíble. #339933 es el código html para un color, siguiendo un patrón Rojo/Verde/Azul. A grandes rasgos, los dos primeros dígitos indican "cuánto" rojo se necesita, los dos segundos indican "cuánto" verde y los dos últimos "cuánto" azul. Al parecer, los usuarios "domésticos" prefieren saberse los códigos html una paleta de colores en lugar de seleccionar el color que prefieran de una lista.

- Otro rasgo negativo de Libreoffice es, al parecer, el no incluir un gestor de información personal (PIM). No pasa nada con que MS no incluya Access en la mayoría de versiones de su suite, ni con que cada vez menos usuarios estén demasiado interesados en ese tipo de herramientas. También se es muy optimista en cuanto a las capacidades de Outlook y, como es de esperar, bastante pesimista en las de otras herramientas. Y bueno, el "a mí me falla" que no puede faltar... Más disculpable es pasar por alto Evolution, ya que no dispone de versión para Windows (hay una mantenida por openSUSE).

El infierno informático

En general, es difícil comparar directamente la usabilidad de sistemas distintos, sean sistemas operativos, aplicaciones de productividad... Yo suelo incluir variables como el tiempo necesario para aprender una característica, el tiempo necesario para utilizarla y la posibilidad de documentarse sobre cómo funciona. Por ejemplo, no considero importante que gimp no tenga una herramienta específica para hacer cuadrados, y no porque la alternativa que utiliza sea fácil o difícil, sino porque es relativamente sencillo utilizar un buscador para ver cómo se hace. Por ejemplo, puedo buscar en google "dibujar cuadrados gimp" (con o sin comillas): https://www.google.es/#q=dibujar+cuadrados+gimp

En las primeras entradas ya podemos ver el proceso para crear cuadrados y otras formas básicas.

Muchos usuarios que comienzan con GNU/Linux preguntan por aplicaciones que sean similares a las que ya usan (cuando no directamente cómo utilizar la misma), en lugar de preguntar por aplicaciones que hagan las mismas cosas que hacían en Windows o Mac. Para ellos, un documento de texto es un "archivo de word", usan "hojas de excel" en lugar de hojas de cálculo, etc.

En otro ejemplo, el menú "clásico" de Windows agrupa las aplicaciones por fabricante. Todo lo más añade un enlace en la lista de "aplicaciones favoritas", pero sin el menor agrupamiento. En GNU/Linux, por supuesto, es inusual que una aplicación coloque un acceso directo en el escritorio, y no lo hará en ningún caso ninguna aplicación de la distribución. A cambio, en el menú estarán todas agrupadas por categoría de aplicación: gráficas, multimedia, utilidades, ofimáticas...

En contra de lo esperado, un usuario de un escritorio Linux copia y pega elementos con comodidad, distribuye aplicaciones por los escritorios para tenerlas más a mano, tiene las aplicaciones ordenadas por su función... Su vida es sencilla.